ChatGPT hat den Turing-Test bestanden! Was kommt als Nächstes?

Eine neue Schlagzeile über die sich rasch weiterentwickelnden Fähigkeiten großer Sprachmodelle (LLMs) wie ChatGPT und Googles Gemini macht Schlagzeilen, Schlagzeilen, die je nach Perspektive entweder aufregend oder zunehmend alarmierend sind.

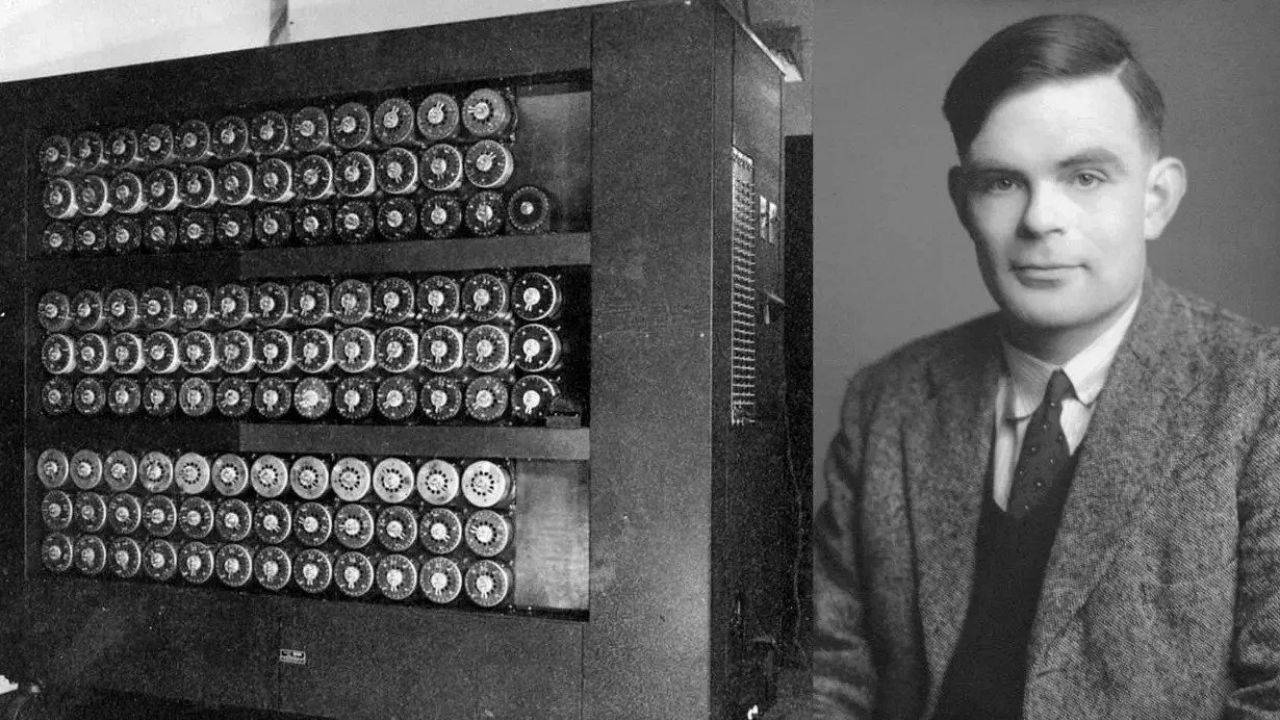

Laut Popular Science Turkish ereignete sich Anfang des Jahres ein besonders bemerkenswerter Fall: Ein Artikel beschrieb, wie ein LLM den Turing-Test bestand. Dieses Experiment, das in den 1950er Jahren vom Informatikpionier Alan Turing entwickelt wurde, sollte herausfinden, ob sich maschinelle von menschlicher Intelligenz unterscheiden lässt. Das in der Studie verwendete LLM war ChatGPT 4.5. Der Artikel stellte fest, dass das Modell Menschen bemerkenswert erfolgreich davon überzeugen konnte, es handele sich um einen Menschen. In einem Experiment, bei dem die Teilnehmer gefragt wurden, ob es sich bei ihrem Gesprächspartner um einen Chatbot oder eine reale Person handele, antworteten fast drei von vier Teilnehmern, es handele sich um eine reale Person.

WAS IST DER TURING-TEST UND WAS NICHT?Um diese Frage zu beantworten, müssen wir uns zunächst ansehen, was der Turing-Test ist und was es für einen LLM bedeutet, den Test zu bestehen oder nicht zu bestehen.

Cameran Jones, Postdoktorand an der University of California in San Diego und Co-Autor der neuen Studie, sagt, Turing habe die Idee zu diesem Test in seinem bahnbrechenden Artikel „Computing Machinery and Intelligence“ aus dem Jahr 1950 entwickelt. Darin widmete sich Turing der tiefgreifenden Frage, die die Menschen damals beschäftigte: „Können Maschinen denken?“

In seinem Artikel weist Turing diese Frage schnell als vage und unseriös zurück und argumentiert, es sei unklar, was in diesem Zusammenhang eine „Maschine“ oder „Denken“ sei. Er schlägt eine differenziertere und verständlichere Antwort vor und stellt die Frage: „Kann sich eine Maschine so verhalten, dass ihre Handlungen nicht von denen eines Menschen zu unterscheiden sind?“ Um diese Frage zu beantworten, schlägt er das sogenannte „Imitationsspiel“ vor. Diese Übung ist inzwischen als „Turing-Test“ bekannt geworden.

Bei dem Test kommuniziert eine Person (der „Vernehmer“) gleichzeitig mit zwei anonymen Gesprächspartnern, den sogenannten „Zeugen“. Die gesamte Kommunikation erfolgt schriftlich. Der Trick besteht darin, dass einer dieser beiden Zeugen eine reale Person ist, während der andere eine Maschine ist. Ziel des Spiels, erklärt Jones, sei es, dass der „Vernehmer herausfindet, welcher der beiden Zeugen die reale Person ist“.

Jones und sein Team führten dieses Experiment mit vier LLMs durch. ChatGPT 4.5 war das mit Abstand erfolgreichste Modell: 73 % der Teilnehmer identifizierten es als echten Menschen. Ein anderes Modell mit einem schwierigen Namen wie LLaMa-3.1-405B wurde in 56 % der Fälle als Mensch identifiziert. (Die beiden anderen Modelle, ELIZA und GPT-4o, hatten Erfolgsraten von 23 % bzw. 21 %. Diese werden nicht erneut besprochen.)

Was bedeutet es, wenn ChatGPT den Turing-Test besteht?Die Ergebnisse von ChatGPT und LLaMa sind schon bemerkenswert genug, aber die wirklich interessante Frage ist, welche Bedeutung der Erfolg der Modelle hat.

Es ist erwähnenswert, dass der Test nicht darauf ausgelegt war, maschinelle Intelligenz zu erkennen. Turing lehnt zwar die Frage „Können Maschinen denken?“ ab, vermeidet aber auch sorgfältig die heikle Frage, wer genau denkt, wenn die Antwort „Ja“ lautet. Erinnern Sie sich an René Descartes' berühmten Satz „Ich denke, also bin ich“, der zeigt, dass Bewusstsein für das Denken unerlässlich ist.

Turing argumentiert in seinem Artikel jedoch, dass der Erfolg im Imitation Game bedeutet, dass wir die Möglichkeit echter Maschinenintelligenz nicht ausschließen können. Wie Jones erklärt, argumentiert Turing: „Wenn wir tatsächlich eine Maschine bauen, die dieses Spiel so gut beherrscht, dass wir Zeugen nicht mehr zuverlässig unterscheiden können, dann müssen wir tatsächlich sagen, dass die Maschine intelligent ist.“

Heutige Leser zögern vielleicht, eine solche Aussage zu machen, daher lohnt es sich, Turings folgende Argumentation zu berücksichtigen:

Wir wissen nicht, ob andere Menschen intelligent sind. Wir können nicht in ihre Gedanken eindringen oder durch ihre Augen sehen. Und doch erkennen wir sie als intelligent an.

Wie treffen wir dieses Urteil? Turing schlägt vor, dass wir es auf der Grundlage des Verhaltens anderer Menschen treffen.

Wenn wir Intelligenz auf der Grundlage von Verhalten zuschreiben und in eine Situation geraten, in der wir nicht zwischen dem Verhalten einer Maschine und dem Verhalten eines Menschen unterscheiden können, sollten wir zu dem Schluss kommen, dass das Verhalten dieser Maschine ebenfalls auf Intelligenz hindeutet.

Auch dies mag Lesern nicht ganz richtig erscheinen. Tatsächlich lautet die Kernfrage in Turings These, dass wir Intelligenz ausschließlich auf Grundlage von Verhalten zuschreiben. Wir werden später auf Gegenargumente eingehen, aber zunächst lohnt es sich zu überlegen, welches Verhalten als Ausdruck von Intelligenz empfunden wird.

WARUM HAT TURING DIE SPRACHE ZUM TESTEN VON MASCHINEN ENTSCHIEDEN?Es ist kein Zufall, dass Turing die Sprache als Grundlage für sein „Imitationsspiel“ wählte. Schließlich gibt es viele Situationen, in denen eine Maschine einen Menschen niemals imitieren könnte, und ebenso gibt es viele Situationen, in denen Menschen eine Maschine niemals imitieren könnten. Doch geschriebene Sprache ist lediglich eine Aneinanderreihung von Buchstaben auf einer Seite. Ob sie von einem Menschen oder einer Maschine geschaffen wurde, ist unklar.

Dennoch gibt die Existenz von Sprache Anlass zu einigen Vermutungen. Seit unsere Vorfahren begannen, Sätze zu bilden, ist die Sprache (zumindest so, wie wir sie kennen) eine ausschließliche Domäne der Menschheit (obwohl sich einige Affen uns immer mehr annähern).

Dies gilt auch für die Art der Intelligenz, die wir zeigen; andere Tiere sind zwar intelligent, aber keines von ihnen denkt wie wir oder scheint über das Selbstbewusstsein des Menschen zu verfügen. Daher ist es nahezu unmöglich, Sprache und Intelligenz nicht miteinander zu verknüpfen. Umgekehrt wird es schwierig, allem, was einen anzusprechen scheint, nicht automatisch ein gewisses Maß an Intelligenz zuzuschreiben.

Rusty Foster, Autor des langjährigen Newsletters „Today in Tabs“, bringt diesen Punkt in einem aktuellen Artikel eindrucksvoll zum Ausdruck. Foster argumentiert, dass wir dazu neigen, Sprache mit Intelligenz zu verwechseln, weil das Vorhandensein von Sprache bisher immer ein Zeichen von Intelligenz war. „Das grundlegende Problem ist, dass generative Sprachsoftware sehr gut darin ist, lange, kontextbasierte Sprachtexte zu generieren, und die Menschheit noch nie zuvor eine kohärente Sprache ohne zugrundeliegendes Bewusstsein erlebt hat“, schreibt Foster. „Im Alltag mussten wir nie zwischen ‚Sprache‘ und ‚Gedanken‘ unterscheiden, weil Sprache nur durch Gedanken erzeugt werden kann.“

Foster weist darauf hin, dass „kleinere“ Beispiele Ausnahmen sind, aber selbst diese wirken überraschend überzeugend. Nehmen wir zum Beispiel einen Papagei. Einen Vogel plötzlich unsere Sprache sprechen zu hören, ist sicherlich überraschend, aber interessanterweise ist es fast unmöglich, nicht zu reagieren. (Es gibt ein Video von einem sehr australischen Papagei und einer sehr australischen Frau, die über die intellektuellen Vorzüge des Familienhundes streiten. Zuschauer, die Sakrileg tolerieren, könnten dieses Beispiel genießen.) Obwohl wir wissen, dass Papageien nicht wirklich wissen, was sie „sagen“, erfordert die Existenz von Sprache Sprache als Antwort.

Und wie sieht es mit LLMs aus? Sind sie tatsächlich energiehungrige Papageien?Jones sagt, das sei „einer der Hauptkritikpunkte“ am Turing-Test. „Die Vorstellung, Intelligenz bedeute intelligentes Verhalten, ist eine extrem behavioristische Sichtweise. Man möchte also, dass andere Bedingungen erfüllt sind: Man möchte, dass eine Maschine das Verhalten korrekt ausführt oder dass sie die richtige Art der Interaktion mit der Welt hat.“

Gedankenexperiment „Chinesisches Zimmer“Es gibt auch Gedankenexperimente, die die Annahmen des Turing-Tests über die Ununterscheidbarkeit von scheinbarer und tatsächlicher Intelligenz in Frage stellen. Jones zitiert John Searles Gedankenexperiment „Chinesisches Zimmer“, das vielleicht berühmteste dieser Experimente, das er 1980 in einem Artikel vorstellte. In dem Artikel stellt sich Searle vor, er befinde sich in einem Raum, in dem jemand Zettel unter der Tür durchschiebt. Diese Zettel enthalten chinesische Schriftzeichen. Searle spricht kein Chinesisch, erhält aber ein Buch mit detaillierten Anweisungen zum Zeichnen chinesischer Schriftzeichen sowie Anweisungen dazu, welche Zeichen er als Antwort auf die Buchstaben zeichnen soll, die er unter der Tür durchschiebt.

Für Außenstehende mag es so aussehen, als würde Searle perfekt Chinesisch sprechen, doch in Wirklichkeit befolgt er lediglich Anweisungen (eines Programms), die ihm sagen, welche Zeichen er wie zeichnen soll. Wie Searle in seinem Artikel erklärt: „An diesem Beispiel wird ganz klar, dass ich kein einziges Wort der chinesischen Geschichten verstehe. Meine Eingaben und Ausgaben sind von denen eines chinesischen Muttersprachlers nicht zu unterscheiden, und ich könnte jedes beliebige formale Programm verwenden und würde trotzdem nichts verstehen.“

Dieses Argument stellt eine klare Ablehnung der Prämisse des Turing-Tests dar. In diesem Artikel argumentiert Searle, dass es einen wichtigen Unterschied zwischen Verstehen und scheinbarem Verstehen sowie Denken und scheinbarem Denken gibt.

CHATGPT IST DAZU EINGERICHTET, MENSCHEN ZU TÄUSCHENDer Artikel weist auch auf ein weiteres potenzielles Problem des Turing-Tests hin: „The Chinese Room“ ist eindeutig darauf ausgelegt, die Person auf der anderen Seite der Tür zu täuschen; anders gesagt: Es handelt sich um ein Programm, das speziell für den Turing-Test entwickelt wurde. Bemerkenswert ist, dass die LLMs, die den Test in Jones‘ Experiment bestanden, ein gewisses Maß an Feinabstimmung benötigten, um überzeugend zu wirken. Jones sagt, sein Team habe eine große Anzahl von Eingabeaufforderungen für den Chatbot getestet, und eine der größten Herausforderungen sei gewesen, „das Modell dazu zu bringen, die Dinge zu tun, die ChatGPT tut“.

Einige der Dinge, die Jones und sein Forschungsteam ChatGPT ermöglicht haben, um zu verhindern, dass es sich wie ChatGPT verhält, sind beeindruckend und drehen sich wiederum um die Nuancen der Sprache. „Man möchte nicht, dass es die ganze Zeit in ganzen Sätzen spricht“, sagt Jones. „Die Leute sprechen beim Texten eher locker – wie Satzfragmente. So etwas muss man verwenden.“

Zusätzlich ließ das Forschungsteam ChatGPT während des Experiments Rechtschreibfehler machen, um es menschlicher zu machen. Die richtige Schreibweise ist tatsächlich ziemlich schwierig. Wenn man einen LLM bittet, sich wirklich anzustrengen, einen Rechtschreibfehler zu machen, macht er ihn Wort für Wort, und die Fehler sehen nicht sehr überzeugend aus. Ich glaube nicht, dass sie ein gutes Modell dafür haben, wie ein Wort aussieht, das mit der falschen Tastenkombination eingegeben wird.

Warum ChatGPT besser ist als andere LLMsLLMs sind schwer zu erforschen. Ihre Funktionsweise ist naturgemäß rätselhaft. Selbst die studienrelevanten Aspekte ihrer Struktur sind durch Vertraulichkeitsvereinbarungen und Unternehmensgeheimnisse geschützt. Dennoch sagt Jones, das Experiment verrate etwas darüber, welcher LLM-Typ sich am besten eignet, um Menschen überzeugend zu imitieren: „ChatGPT 4.5 galt als eines der größten Modelle, und ich denke, es ist sehr nützlich, ein großes Modell zu haben.“

Was bedeutet „groß“ in diesem Zusammenhang? Eine große Codebasis? Ein großer Datensatz? Nein, sagt Jones. Er erklärt, dass ein großes Modell eine relativ große Anzahl interner Variablen hat, deren Werte angepasst werden können, wenn das Modell Trainingsdaten einbezieht. „Wir sehen, dass kleinere Destillatmodelle Mathematik und sogar sehr einfache Logik sehr gut simulieren können. Aber ich denke, es sind die sehr großen Modelle, die im Allgemeinen gute soziale und zwischenmenschliche Verhaltensfähigkeiten aufweisen.“

Hat Turing ChatGPT vorhergesagt?Aber hat Turing diesen von ihm entwickelten Test jemals als tatsächlich umsetzbar angesehen? Oder war es eher ein Gedankenexperiment? Jones sagt, die Antwort auf diese Frage sei unter Turing-Forschern noch immer umstritten. Er beziehe sich ausschließlich auf die Arbeit selbst. „Ich denke, man kann sie so lesen, dass man dieses Experiment irgendwann in der Zukunft durchführen könnte.“

Jones sagt jedoch: „Turing hat offensichtlich keine Methodik dargelegt. Daher glaube ich nicht, dass er dachte, dieses Experiment würde es wert sein, jahrzehntelang durchgeführt zu werden. Er hat also nicht gesagt, wie lange es dauern sollte oder, ich weiß nicht, ob es Regeln geben sollte und worum es dabei gehen könnte.“

Wenn Turing voraussagte, dass dieser Test bestanden werden könnte, wusste er in den 1950er Jahren sicherlich, dass dies nicht passieren würde. Doch sein Artikel zeigt, dass er sich zumindest die Möglichkeit vorstellte, dass wir eines Tages erfolgreiche Maschinen bauen könnten: „Wir fragen nicht, ob alle digitalen Computer in der Lage sein werden, diese Aufgabe zu bewältigen, oder ob heutige Computer diese Aufgabe gut erledigen werden, sondern ob Computer, die diese Aufgabe gut erledigen, vorstellbar sind“, schreibt er.

Turing wurde oft (zu Recht) als vorausschauend beschrieben, doch in diesem Aufsatz von 1950 gab es einen Absatz, der eine erstaunliche Weitsicht bewies: „Ich denke, in etwa 50 Jahren wird es möglich sein, Computer so zu programmieren, dass sie dieses Imitationsspiel so gut spielen, dass der durchschnittliche Vernehmer nach fünf Minuten Befragung nur noch eine 70-prozentige Chance hat, die richtige Antwort zu geben.“

Es hat 75 Jahre gedauert, nicht 50, aber wir haben diesen Punkt erreicht: Wir stehen tatsächlich einem Computer (oder zumindest einem computergenerierten Modell) gegenüber, der die Menschen in 70 % der Fälle täuscht.

Was macht die menschliche Intelligenz einzigartig?All das bringt uns zurück zur ursprünglichen Frage: Was bedeutet das alles? „Ich ringe immer noch mit dieser Frage“, sagt Jones lachend.

„Ein Gedankengang, den ich für hilfreich halte, ist, dass der Turing-Test weder ein notwendiger noch ein ausreichender Beweis für Intelligenz ist. Man kann sich vorstellen, dass etwas Intelligentes den Test nicht besteht, weil es nicht die richtige Fachsprache verwendet, und dass etwas Unintelligentes den Test besteht.“

Letztendlich, so Jones, liege das wichtigste Ergebnis auf der Hand: „Dies ist der Beweis, dass diese Modelle menschenähnliches Verhalten so gut nachahmen können, dass Menschen es nicht einmal erkennen können.“ Dies könnte offensichtlich zu allen möglichen Konsequenzen führen, von denen viele für die Öffentlichkeit und die wissenschaftliche Gemeinschaft von größerem Interesse zu sein scheinen als für die Unternehmen, die die LLMs herstellen.

An dieser Stelle stellen sich weitere philosophische Fragen. Turing geht in seinem Artikel auf einige davon ein, die bemerkenswerteste davon ist das sogenannte „Argument des Bewusstseins“. Kann eine Maschine ein Bewusstsein haben, auch wenn sie intelligent ist? Turing führt als Beispiel ein Gespräch an, das seiner Vermutung nach zwischen einem Menschen und einer Maschine stattgefunden hat, die Gedichte schrieben – ein Gespräch, das dem heutigen Gespräch mit ChatGPT verblüffend ähnelt. Das Gespräch ist ein Beispiel dafür, wie man es analysieren könnte, um herauszufinden, „ob der Autor ein Thema wirklich versteht oder es nur wie ein Papagei auswendig lernt“.

Natürlich stellen sich hier noch viele weitere philosophische Fragen. Die vielleicht beunruhigendste ist diese: Wenn wir den Turing-Test nicht als zuverlässige Methode zur Erkennung echter KI betrachten, haben wir dann eine Alternative? Oder anders ausgedrückt: Gibt es eine andere zuverlässige Methode, um festzustellen, wann oder ob eine Maschine tatsächlich über Intelligenz verfügt?

„Ich denke, die meisten Menschen würden sagen, dass unser Kriterium für Bewusstsein über das Verhalten hinausgehen sollte“, sagt Jones. „Wir könnten uns etwas vorstellen, das dasselbe Verhalten wie ein bewusstes Wesen zeigt, ohne bewusste Erfahrung zu haben. Vielleicht sollten wir zusätzliche Kriterien hinzufügen.“

Es ist noch nicht klar, welches Kriterium dieses sein soll und ob es überhaupt ein entscheidendes Kriterium für die Intelligenz eines Lebewesens ist. Schließlich ist nicht einmal klar, ob wir ein solches Kriterium für einen ähnlichen Test bei Tieren haben. Als Menschen sind wir fest davon überzeugt, irgendwie einzigartig zu sein. Doch im Laufe der Jahre hat sich gezeigt, dass Eigenschaften, die einst als einzigartig menschlich galten, dies nicht sind. Beispiele hierfür sind der Gebrauch von Werkzeugen, die Bildung von Gemeinschaften und das Erleben von Empathie.

Und doch fällt es uns schwer, den Gedanken loszulassen, dass wir anders sind. Es ist nur überraschend schwierig, genau zu bestimmen, wie. Und genau deshalb ist es unglaublich schwierig, den Ursprung dieses Unterschieds zu bestimmen. Wo hören wir auf, Elektrolytsäcke zu sein, und beginnen, bewusste Wesen zu sein? Offenbar ist das keine einfachere Frage, als herauszufinden, wo in den verwirrend komplexen elektrischen Signalen in Computer-CPUs Bewusstsein entsteht.

Turing ist auch hierauf eine Antwort. „Ich möchte nicht den Eindruck erwecken, ich glaube, das Bewusstsein sei kein Mysterium. So ist beispielsweise jeder Versuch, den Ort des Bewusstseins zu bestimmen, paradox.“ Turing argumentiert, dass es zur Beantwortung der Testfrage nicht notwendig sei, den Ursprung des menschlichen Bewusstseins zu verstehen.

Im engsten Sinne hat er Recht: Die Tatsache, dass eine Maschine einen Menschen zuverlässig imitieren kann, sagt nichts über das Bewusstsein aus. Doch der Wirbel um ChatGPTs Bestehen des Turing-Tests sagt viel über die Zeit aus, in der wir leben: eine Zeit, in der es entscheidend sein kann, zu wissen, ob echte künstliche Intelligenz überhaupt möglich ist.

Um zu verstehen, ob eine Maschine intelligent sein könnte, müssen wir vielleicht zunächst verstehen, wie und wo Intelligenz in Lebewesen entsteht. Dies könnte uns Aufschluss darüber geben, ob eine solche Entwicklung bei Computern möglich ist oder ob es das Beste ist, Programme zu entwickeln, die uns das Internet mit all seinen Vorurteilen und Voreingenommenheiten überzeugend nachplappern.

Cumhuriyet